- 歡迎使用超級蜘蛛查,網站外鏈優化,收藏快捷鍵 CTRL + D

搜索引擎蜘蛛抓取策略,如何吸引更多蜘蛛

在SEO工作中,有的時候我們很少關心搜索引擎蜘蛛是如何工作的,雖然,它是一個相對復雜的工作系統,但對于SEO人員而言,我們有必要進行詳盡的了解,它有利于指導我們有效的工作。

下面解讀主流搜索引擎蜘蛛是如何工作的:

一、常見搜索引擎蜘蛛抓取策略:

1、深度優先遍歷策略

簡單理解,深度優先遍歷策略主要是指建立一個起點,按照這個起點的順序,順序抓取鏈條上,沒有被抓取的每個節點。但有的時候,面對“無限循環”節點的時候,這一策略便顯得捉禁見肘。

2、寬度優先遍歷策略

寬度優先便利策略,是早期搜索引擎常用的一種抓取策略,主要流程是提取整個頁面中的URL,其中未被抓取的URL,就被放入待抓取列隊,以此循環。

3、PR優先策略

RP優先策略是一個非常注明的鏈接分析方法,它用于衡量網頁的重要性,通常它會計算一個頁面上URL的PR,按照從高到低的順序進行抓取。

由于PR值的計算,需要不斷的迭代更新,通常這里所采用的都是非完全PageRank策略。

4、反鏈策略

反鏈策略,并沒有一個明確的官方文檔說明,這里小編認為,它主要是基于反鏈的數量以及種子頁面的權威度,二者進行加權評估后,按照優先順序抓取。

5、社會化媒體分享策略

社會化媒體分析策略,主要是指一個URL在社交媒體中的流行度,它的轉載量,評論,轉發量,綜合指標的評估。

如果你的URL最先沒有在百度網址提交,而是出現在社交媒體中,比如:頭條文章,也是很有可能被百度抓取的。

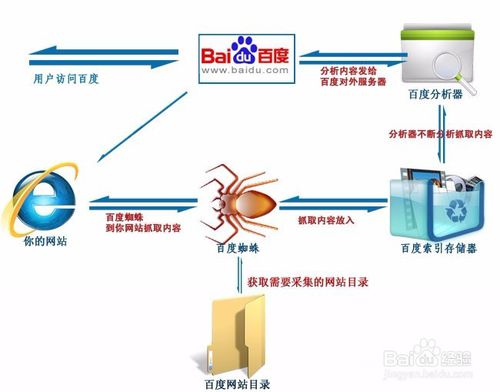

6、爬行原理

搜索引擎蜘蛛訪問網頁的過程,就好比用戶使用的瀏覽器。

搜索引擎蜘蛛向頁面發出訪問請求,該頁面的服務器則返回該頁面的HTML代碼。

搜索引擎蜘蛛將收到的HTML代碼存入搜索引擎的原始頁面數據庫中。

7、如何爬行

為了提高搜索引擎蜘蛛的工作效率,通常采用多個蜘蛛并發分布爬行。

同時,分布爬行還分為兩種模式:深度優先和廣度優先。

深度優先:沿著發現的鏈接一直爬行,直到沒有任何鏈接。

廣度優先:先這一頁面上的所有鏈接爬行完畢之后,才會沿著第二層頁面繼續這樣爬行。

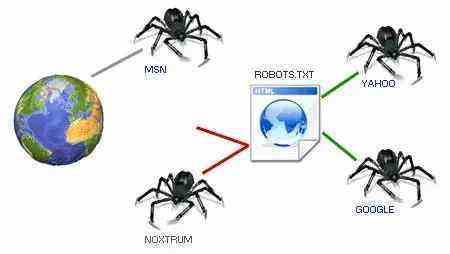

8、蜘蛛必遵守的協議

搜索引擎蜘蛛在訪問網站之前,都會先訪問網站根目錄下的robots.txt文件。

搜索引擎蜘蛛不會去抓取robots.txt文件中禁止爬行的文件或目錄。

9、常見搜索引擎蜘蛛

百度蜘蛛:Baiduspider

谷歌蜘蛛:Googlebot

360蜘蛛:360Spider

SOSO蜘蛛:Sosospider

有道蜘蛛:YoudaoBot,YodaoBot

搜狗蜘蛛:Sogou News Spider

必應蜘蛛:bingbot

頭條蜘蛛:Bytespider

Alexa蜘蛛:ia_archiver

二、如何吸引更多搜索引擎蜘蛛

互聯網信息爆炸,搜索引擎蜘蛛不可能將所有網站的所有鏈接全部爬行到,那么如何吸引更多的搜索引擎蜘蛛到我們網站上來爬行變得非常重要。

1、 導入鏈接

無論是外部鏈接,還是內部鏈接,只有有導入,才能被搜索引擎蜘蛛知道該頁面的存在。所以,多多做外鏈建設有助于吸引更多蜘蛛來訪。

2、頁面更新頻率

頁面更新頻率越高,搜索引擎蜘蛛來訪的次數也會越多。

3、網站和頁面權重

整個網站的權重以及某一頁面的權重(包括首頁也是頁面)影響著蜘蛛的來訪頻率,權重高、權威性強的網站一般都會增加搜索引擎蜘蛛的好感。

4、與首頁的距離

首頁>一級目錄>二級目錄>三級目錄>四級目錄…很顯然,目錄越深蜘蛛來訪的幾率和次數就會越少,因為一般外鏈都是指向首頁的,首頁再向下爬行,只會越來越少。

這里給大家的建議是,做外鏈的時候,不要只做首頁外鏈,偶爾做一做欄目和聚合頁面的外鏈也還是不錯的哦~

有些時候,URL短,蜘蛛可能也會覺得這個鏈接的權重哦,所以,最好只做一級欄目,然后就是文章頁面。

三、搜索引擎蜘蛛地址庫

搜索引擎蜘蛛有一個專門的地址庫,用來存放已經被發現的URL(已被抓取和未被抓取的都算,只要是被發現的URL都算),這樣就不會出現重復爬行和抓取頁面的情況了。

1、地址庫URL來源

蜘蛛抓取的頁面中發現的新的URL;

站長后臺自主提交的URL;

站長后臺提交的XML地圖中的URL;

站長后臺提交的網站URL;

2、對于未被抓取的URL

對于未被抓取的URL,不管是以什么方式獲取的,哪怕是搜索引擎蜘蛛自己發現的,也會先放入地址庫中,然后在做統一抓取。

四、頁面數據存儲

搜索引擎蜘蛛將抓取的頁面數據會存入搜索引擎的原始頁面數據庫中,其實,就可以理解為快照中看到的頁面數據,和用戶看到的是一樣的,每一個頁面的URL地址都有一個唯一的編號。

五、原創內容檢測

搜索引擎蜘蛛在爬行的過程中,會進行一定程度的原創內容檢測。如果是權重低的網站上,發現了大量的轉載或抄襲內容時,可能會停止爬行,這些頁面可能也會不抓取與收錄。

但并不是說網站就不能轉載,像一些權重很高的平臺,哪怕是轉載了一篇舊聞排名也可以很好,因為搜索引擎蜘蛛可能會覺得,就算是舊聞可能也是高質量的吧。