- 歡迎使用超級蜘蛛查,網站外鏈優化,收藏快捷鍵 CTRL + D

搜索引擎蜘蛛收录网站robots.txt设置方法

有沒有擔心過自己的隱私會在強大的搜索引擎面前無所遁形?想象一下,如果要向世界上所有的人公開你的私人日記,你能接受嗎?的確是很矛盾的問題,站長們大都憂慮“如何讓搜索引擎收錄的我的網站?”,而我們還是要研究一下“如何讓搜索引擎不收錄我們的網站”,也許我們同樣也用的到。

一、搜索引擎如何工作的?

簡單的說,搜索引擎實際上依靠的龐大的網頁數據庫。按搜索方式可以分為 全文搜索 和 目錄搜索 兩種。

所謂全文搜索,是搜索引擎通過從網頁自動提取信息來建立數據庫的過程。至于提取的原理,就是SEO狂熱者們所研究的算法,在他們的理想情況下,網頁應該是針對搜索引擎設計的,具有最好的收錄效果。當然,不是本文的話題。搜索引擎的自動信息搜集功能分兩種。一種是定期搜索,即每隔一段時間(比如Google一般是28天),搜索引擎主動派出“蜘蛛”程序,對一定IP地址范圍內的互聯網站進行檢索,一旦發現新的網站,它會自動提取網站的信息和網址加入自己的數據庫。另一種是提交網站搜索,即網站擁有者主動向搜索引擎提交網址,它在一定時間內(2天到數月不等)定向向你的網站派出“蜘蛛”程序,掃描你的網站并將有關信 息存入數據庫,以備用戶查詢。

與全文搜索引擎相比,目錄索引有許多不同之處。目錄索引完全是手工操作的。

首先,搜索引擎屬于自動網站檢索,而目錄索引則完全依賴手工操作。用戶提交網站后,目錄編輯人員會親自瀏覽你的網站,然后根據一套自定的評判標準甚至編輯人員的主觀印象,決定是否接納你的網站。

其次,搜索引擎收錄網站時,只要網站本身沒有違反有關的規則,一般都能登錄成功。而目錄索引對網站的要求則高得多,有時即使登錄多次也不一定成功。尤其象Yahoo!這樣的超級索引,登錄更是困難。

最后,搜索引擎中各網站的有關信息都是從用戶網頁中自動提取的,所以用戶的角度看,我們擁有更多的自主權;而目錄索引則要求必須手工另外填寫網站信息,而 且還有各種各樣的限制。更有甚者,如果工作人員認為你提交網站的目錄、網站信息不合適,他可以隨時對其進行調整,當然事先是不會和你商量的。

目錄索引,顧名思義就是將網站分門別類地存放在相應的目錄中,因此用戶在查詢信息時,可選擇關鍵詞搜索,也可按分類目錄逐層查找。如以關鍵詞搜索,返回的結果跟搜索引擎一樣,也是根據信息關聯程度排列網站,只不過其中人為因素要多一些。

二、如何拒絕搜索引擎?

其實很簡單的,只需要在網站的根目錄中放一個名稱為Robots.txt的文件,該文件的寫法很有講究的哦,務必按要求寫,寫法如下:

1、什么是Robots.txt?

Robots.txt是一個文本文件,關鍵是這個文件所在的位置:在網站的根目錄下。弄錯了,就不起作用了!

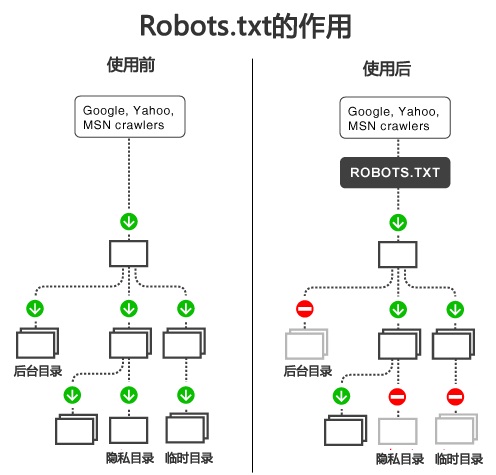

2、Robots.txt如何起作用?

前面提到過搜索引擎的自動提取信息會遵循一定的算法,但是,無論算法如何,第一步都是在尋找這個文件。其含義是,“貴站對我們這些Robots有什么限制?”所謂的Robots就是搜索引擎派出的蜘蛛或者機器人。如果沒有得到回應(沒有找到這個文件),代表沒有什么限制,盡管來抓取吧。如果真的有這個文件,機器人會讀來看看,如果自己被拒絕就會停止抓取過程了。

3、怎么寫Robots.txt文件?

遵循語法的Robots.txt才可能被機器人識別,至于語法,介紹起來很繁瑣,現簡單舉例如下:

1)禁止所有搜索引擎訪問網站的任何部分(也就是網站徹底的拒絕所有搜索引擎收錄)

User-agent: * Disallow: /

2)允許所有的robot訪問(也就是網站允許所有搜索引擎收錄)

User-agent: * Disallow:

3)禁止某個搜索引擎的訪問(比如禁止百度收錄,按如下的方式寫)

User-agent: baiduspider Disallow: /

4)允許某個搜索引擎的訪問(比如允許百度收錄,按如下的方式寫)

User-agent: baiduspider Disallow: User-agent: * Disallow: /

5)禁止搜索引擎訪問某些目錄

User-agent: * Disallow: /cgi-bin/ Disallow: /tmp/ Disallow: /images/

使用方法:很簡單,將代碼存為一個文本文件,命名為Robots.txt ,放在網頁根目錄即可。

注意:所有語句都是單規則的,即每行僅聲明一條規則,比如例五中三個目錄必須分三行列出來。